카카오가 국내 공개 모델 중 최고 성능의 경량 멀티모달 언어모델, 전문가 혼합(MoE) 모델을 오픈소스로 공개했다. 지난 5월 언어모델 4종 공개 이어 약 두 달 만으로 독자적인 AI 모델 기술 개발 역량을 증명했다.

카카오는 24일 허깅페이스를 통해 멀티모달 언어모델 '카나나 1.5-v-3b'와 MoE 언어모델 '카나나 1.5-15.7b-a3b'를 오픈소스로 공개했다.

지난 5월 공개한 언어모델 카나나 1.5 4종에 이어 두 달 만에 추가 모델을 오픈소스로 선보였다.

'카나나 1.5-v-3b'는 이미지, 텍스트 입력 시 자연어로 응답하는 경량 멀티모달 언어모델이다. 모델 개발의 처음부터 마지막 단계까지 카카오의 자체 기술을 바탕으로 구축하는 '프롬 스크래치' 방식으로 개발됐다.

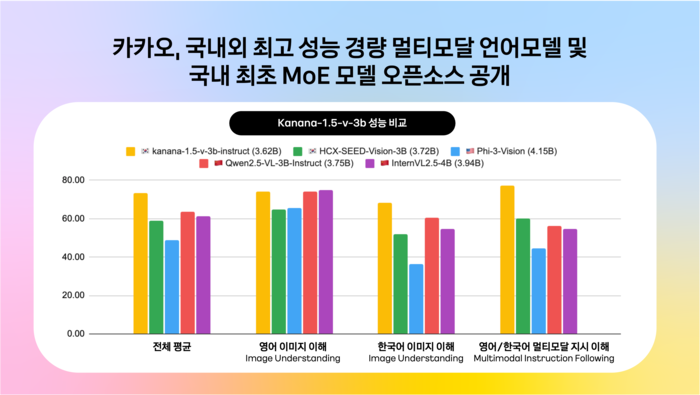

이 모델은 이용자의 질문 의도를 정확히 이해하는 높은 지시 이행 성능과 뛰어난 한국어·영어 이미지 이해 능력을 보유했다. 카카오는 경량 모델임에도 이미지로 표현된 한국어와 영어 문서 이해 능력이 글로벌 멀티모달 언어모델 'GPT-4o'와 견줄 수 있을 정도로 뛰어나다고 설명했다.

한국어 벤치마크에서 유사 사이즈 국내외 공개 모델과 비교한 결과 최고 점수를 기록했다. 다양한 영어 벤치마크에서 해외 오픈소스 공개모델과 비교했을 때도 유사한 수준 성능을 보였다. 지시 이행 능력 벤치마크에서는 국내 공개된 유사한 규모 멀티모달 언어모델 대비 128% 수준 성능을 기록했다.

'카나나 1.5-v-3b'는 이미지·글자 인식, 동화·시 창작, 국내 문화유산 및 관광지 인식, 도표 이해, 수학 문제풀이 등 여러 분야에서 활용할 수 있다. 한 예로 장소 사진과 함께 “이 사진이 촬영된 장소에 대해 간단히 설명해줘”라고 질문하면 “이 사진은 서울 청계천을 배경으로 하고 있습니다”와 같이 정확한 답변을 제공한다. 이미지 검색, 콘텐츠 분류 등에도 활용할 수 있다.

카카오는 이 날 MoE 아키텍처를 적용한 '카나나 1.5-15.7b-a3b'도 공개했다. MoE는 특정 작업에 최적화된 일부 전문가 모델만 활성화하는 방식이다. 효율적으로 컴퓨팅 자원을 활용해 비용을 줄일 수 있다. 프랑스 미스트랄, 중국 딥시크 등이 이 방식을 적극적으로 활용했다.

카카오는 MoE 모델을 오픈소스로 공개하면서 고성능 AI 인프라를 저비용으로 구축하고자 하는 기업이나 연구 개발자에게 실용적인 도움을 제공할 것으로 기대했다. 특히 추론 과정에서 제한된 파라미터만 사용하는 구조적 특성 덕분에 저비용, 고효율 서비스를 구현하기 유리하다.

카카오는 올해 하반기 에이전트형 AI 구현에 필수적인 추론 모델 성과도 공개할 예정이다.

김병학 카카오 카나나 성과리더는 “이번 오픈소스 공개는 비용 효율성과 성능이라는 유의미한 기술 개발 성과를 거둔 것”이라면서 “단순한 모델 아키텍처 진보를 넘어 서비스 적용과 기술 자립이라는 두 가지 측면 목표에 부합하는 결과물”이라고 말했다.

변상근 기자 sgbyun@etnews.com

![[GAM]메타 주가 7월30일 '분수령' ② AI 모멘텀 월가 기대치는](https://img.newspim.com/news/2025/07/24/2507240217481460.jpg)

![[체험기] "플렉스 모드가 '플렉스' 했네"...삼성 갤럭시 Z 플립7 써보니](https://image.mediapen.com/news/202507/news_1032059_1753419508_m.jpg)