엔비디아가 차세대 인공지능(AI) 반도체에 적용하는 고대역폭메모리(HBM) 용량을 대거 늘린다. 3년 뒤에는 지금보다 5배 많은 용량의 HBM을 탑재할 예정이다. 급증하는 AI 연산 수요에 대응하기 위한 전략이다. HBM 성장동력이 견고하다는 것을 재확인했다.

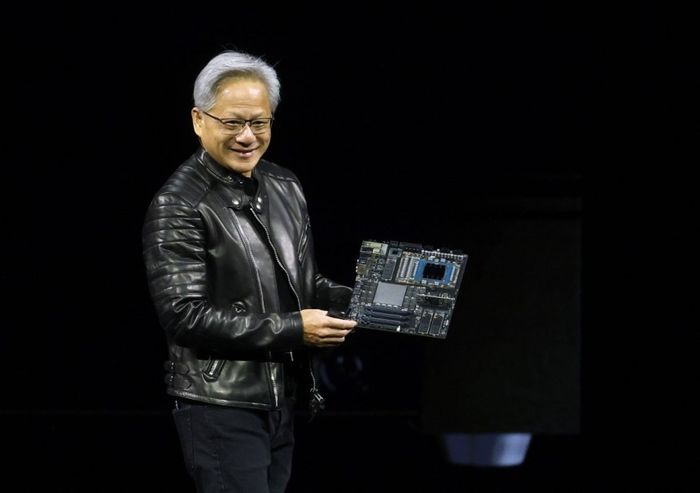

엔비디아는 18일(현지시간) 미국 캘리포니아 산호세 SAP 센터에서 열린 AI 콘퍼런스 'GTC 2025'에서 차세대 AI 반도체 로드맵을 공개했다. 작년 말 양산한 블랙웰 이후 제품 사양이 알려진 건 이번이 처음이다.

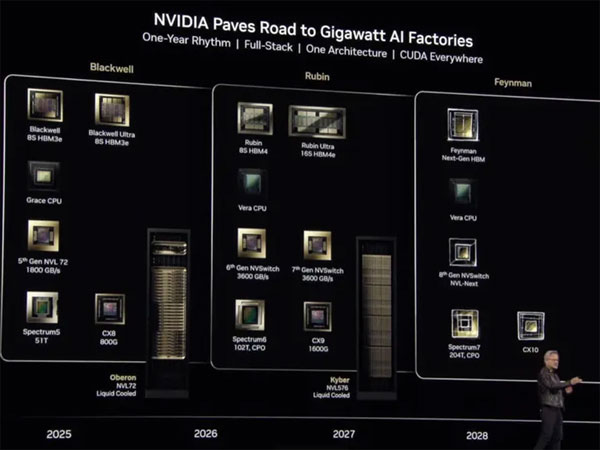

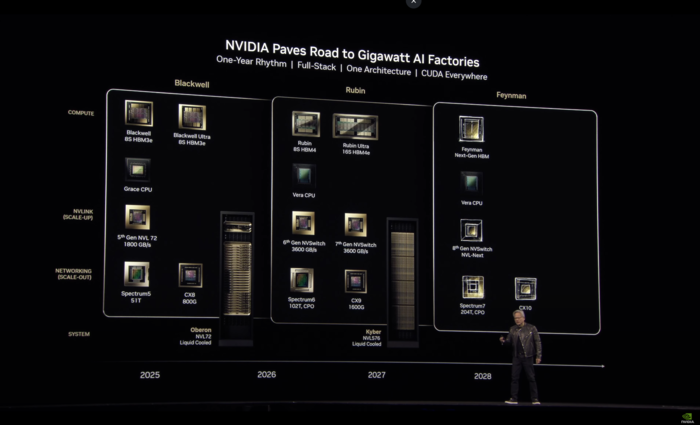

엔비디아는 올 하반기 블랙웰 업그레이드 버전인 '블랙웰 울트라'를 선보인다. 내년 하반기에는 '루빈'을, 2027년 '루빈 울트라'를 출시할 계획이다. 2028년에는 '파인만'을 내놓는다.

세대를 거듭할수록 HBM 용량이 대폭 늘어나는 것이 특징이다. AI 반도체는 그래픽처리장치(GPU) 옆에 복수의 HBM을 탑재해 AI 연산을 돕는데, AI 연산량이 커지면서 HBM 수요도 늘어날 것으로 관측된다.

구체적으로 현재 블랙웰에는 HBM3E 192기가바이트(GB)가 적용되는데, 블랙웰 울트라에서는 288GB로 50% 증가한다. 루빈에서는 HBM4 288GB가, 루빈 울트라에는 HBM4E 1테라바이트(TB)로 다시 3배 이상 급증한다.

특히 3년 뒤 출시되는 루빈 울트라는 현재 대비 5배 많은 HBM 용량을 요구한다. 극대화된 GPU 병렬 처리 성능을 지원하기 위해서다. 루빈 울트라는 GPU 4개가 하나로 패키지 되는 첫 제품으로, AI 처리 능력이 대폭 커져 고용량 HBM이 필요해졌다.

루빈 울트라는 AI 추론(FP4) 성능이 100 페타플롭스(PetaFLOPS)다. 초당 10경번 AI 연산을 수행할 수 있다는 의미다. 블랙웰의 10배 개선된 성능으로, 이를 위해 보다 많은 HBM을 탑재해야 하는 것으로 분석된다.

2028년 출시될 파인만의 HBM 사양은 구체적으로 공개되지 않았다.

엔비디아의 HBM 탑재량이 단기간 급증하면서 HBM 성장세는 지속될 것으로 예상된다. 일부 AI 반도체 업계에서 HBM 대안을 찾으려고 시도 중이지만, 시장 1위인 엔비디아가 계속 HBM 적용을 늘려갈 것으로 전망돼서다.

메모리 제조사 간 경쟁도 한층 치열해질 전망이다. 현재 SK하이닉스, 마이크론이 최신 HBM을 공급 중이며 삼성전자도 공급망 진입을 시도하고 있다. 시장조사업체 테크인사이츠는 올해 HBM 출하량이 전년 대비 70% 늘어날 것으로 예상했다.

엔비디아는 AI 반도체 수요 역시 계속 확대 중이라고 거듭 강조했다. 일각에서 제기하는 AI 반도체 성장 둔화 우려를 일축한 것이다.

일례로 상위 4개 클라우드 회사(아마존·마이크로소프트·구글·오라클)가 지난해 구매한 전 세대 AI 반도체 호퍼 대비 올해 블랙웰 구매량이 3배 이상이라고 전했다. 또 데이터센터 설비투자액(CAPEX)이 이르면 2028년께 1조 달러(약 1450조원)를 넘어설 것이라고 내다봤다.

젠슨 황 엔비디아 최고경영자(CEO)는 “추론 AI와 AI 에이전트 시스템의 학습으로 인해 수행해야 할 계산량이 작년 이맘 때 예상보다 100배는 더 많다”며 엔비디아 AI 반도체 수요가 이어질 것이라고 강조했다.

박진형 기자 jin@etnews.com