유튜브가 최근 자녀 보호 서비스를 강화한데 이어 메타가 내년 국내에서 ‘10대 계정’을 도입한다. 청소년들의 소셜네트워크서비스(SNS) 사용이 늘어나고 숏폼 중독이 사회 문제로 떠오른 가운데 대책 마련에 나선 것으로 분석된다.

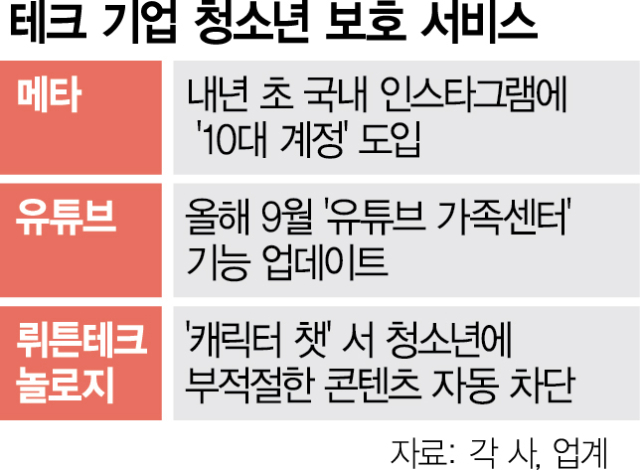

11일 업계에 따르면 메타는 청소년 안전을 위해 내년 1월부터 국내에서 10대 계정을 도입한다. 9월 미국·캐나다·영국·호주 등 4개국에서 서비스를 선보인 데 이어 국내까지 확대하는 것이다. 해당 기능은 18세 미만 이용자의 인스타그램 계정을 비공개로 전환하고, 부모가 관리·감독할 수 있도록 하는 것이 핵심이다. 또 폭력이나 술, 도박 등 민감한 콘텐츠에 대한 노출을 낮추고 팔로잉 관계가 아닌 낯선 사람이 보내는 개인 메시지도 제한된다. 이 외에도 일정 시간 이상 애플리케이션(앱)을 사용하면 경고 알림이 표시되는 등 앱 이용 시간 관리도 도와준다.

유튜브도 올해 9월 자녀 보호 서비스인 ‘유튜브 가족 센터’의 기능을 업데이트했다. 부모는 자녀가 운영하는 채널을 함께 관리할 수 있을 뿐만 아니라 다른 동영상에 게시한 댓글 수나 구독 중인 채널 수 등도 확인할 수 있다. 아울러 청소년이 새 동영상을 업로드하거나 라이브 스트리밍을 할 때 부모의 계정으로 알림이 전송된다.

국내 정보기술(IT) 기업들도 청소년 보호 기능 강화에 나섰다. 네이버가 인공지능(AI) 기능을 강화해 자사 플랫폼 내 불법 자료를 자동으로 삭제하고 있고, 뤼튼테크놀로지스는 ‘캐릭터 챗’ 서비스서 청소년에 부적절한 콘텐츠를 자동으로 차단하는 기능을 도입했다.

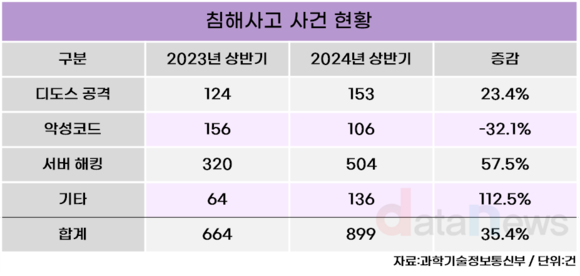

이 같은 움직임은 기술의 발전으로 청소년 대상 IT 범죄 증가 등 부작용이 잇따르면서 기업들이 대책 마련에 나선 것으로 분석된다. 동시에 SNS에 대한 청소년들의 중독 현상이 사회 문제로 떠오른 것도 영향을 미친 것으로 풀이된다. 실제로 여성가족부의 ‘2024년 청소년 미디어 이용습관 진단조사’에 따르면 조사 참여 청소년 약 125만 명 중 22만 명이 인터넷 또는 스마트폰 과의존 위험군으로 분류됐다. 해외에서도 비슷한 현상이 잇따르며 미국 캘리포니아주 등 33개 주 정부는 메타가 과도한 중독성으로 청소년 정신 건강에 피해를 주고 있다며 소송을 냈고, 유럽연합(EU)도 공식 조사에 착수한 상태다.