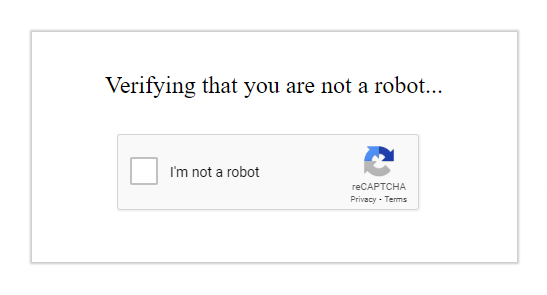

인터넷을 할 때 사용자들은 '로봇이 아닙니다'(I am not a robot)라는 문구가 적힌 체크박스를 종종 볼 수 있다. 이는 사용자가 실제 사람인지 컴퓨터 프로그램인지를 판가름하는 클라우드 기반 보안 필터인 '캡차'(CAPTCHA; Completely Automated Public Turing test to tell Computers and Humans Apart)다.

단순히 체크박스를 누르는 행동이지만, 로봇이 이 행동을 '인간처럼' 수행하기는 쉽지 않다. 캡차는 이 행동 하나를 수행하는 데 있어 마우스의 이동 경로나 클릭 속도, 움직임 등을 분석하는 데다, 과거 웹 사용 패턴이나 사용자의 브라우저 쿠키 등을 종합적으로 고려하기 때문이다.

이 가운데 오픈AI의 최신 모델 '챗GPT 에이전트'가 최근 이 테스트를 스스로 통과해 논란이 되고 있다.

29일(현지시간) 영국 텔레그래프에 따르면 최근 미국 커뮤니티 레딧에는 현재 유료 버전에서 사용이 가능한 '챗GPT 에이전트'가 보안 필터를 통과했다는 사연이 전해졌다.

해당 사용자는 챗GPT를 사용하는 화면 스크린샷을 공유하면서 “챗GPT는 사이버보안업체 클라우드플레어(Cloudflare)에서 인증을 완료하기 위해 '로봇이 아닙니다' 체크박스를 클릭하겠다는 안내 메시지가 띄웠다”고 전했다.

그가 공유한 이미지를 보면 챗GPT는 “이제 '당신이 사람임을 확인하세요' 체크박스를 클릭해 인증을 완료하겠다. 이 단계는 제가 봇이 아님을 증명하고 다음 작업으로 진행하기 위해 필요한 작업”이라고 설명하더니 캡차 절차를 통과한 뒤 다음 작업으로 넘어갔다.

이 사용자는 “클라우드플레어는 자동화된 트래픽을 차단하는 데 사용하는 일반적인 보안 장치 중 하나”라면서 “퍼즐 형식의 캡차보다 자주 사용되기 때문에 테스트 방식을 다시 설계해야 한다”고 지적했다.

오픈AI는 이달 중순 챗GPT 에이전트를 공개하고 “챗GPT는 이제 자체 컴퓨터를 사용해 복잡한 작업을 처음부터 끝까지 처리할 수 있게 됐다”고 설명했다.

이로 인해 AI의 높은 자율성이 민감한 정보 유출로 이어질 수 있다는 우려의 목소리가 제기됐다.

오픈AI는 “우리는 통제 조치를 강화하는 한편 라이브 웹에서 민감한 정보를 처리하고, 사용자 도달 범위를 확대하고, (제한된) 터미널 네트워크 접근과 같은 과제에 대한 보호 장치를 추가했다”고 설명했지만 챗GPT 에이전트로 정보 유출의 위험도가 증가했다는 사실은 인정했다.

AI 윤리 전문가들은 자율적으로 동작하는 AI의 위험성을 경고하고 있다. AI 윤리 스타트업 휴메인 인텔리전스의 공동 창업자 럼만 차우더리(Rumman Chowdhury)는 “스스로 행동하고 인간의 문턱을 넘는 자율 에이전트는 강력하고 위험하다”면서 이를 규제할 국제 규칙의 필요성을 강조했다.

서희원 기자 shw@etnews.com

![[사진] KT, 국내 최초 AI 보이스피싱 탐지 서비스](https://pds.joongang.co.kr/news/component/htmlphoto_mmdata/202507/31/d69dca9b-c879-4706-bba2-6c498d6d2672.jpg)