챗 GPT 같은 초거대언어모델(LLM)은 언어를 정교하게 구사하는 능력에서 놀라운 진전을 이뤘다. 하지만 ‘환각’(hallucination)이라 불리는 허위 정보 생성 문제는 본질적인 한계로 남아 있다. 이는 특히 ‘판단과 의사결정’(JDM)이 요구되는 상황에서 LLM의 활용을 제약해왔다.

약점 보완을 위해 2021년 ‘생각의 사슬(CoT)’ 기법이 제안됐다. CoT는 모델이 정답을 즉각 산출하는 대신, 인간처럼 사고 과정을 단계적으로 전개하도록 유도한다. 수학과 과학적 추론, 복잡한 대화 처리 등 다양한 영역에서 CoT는 성과를 입증하고 있다.

최근 LLM 개발사들은 CoT를 단순한 기술이 아닌 핵심 훈련 전략으로 채택하고 있다. GPT-4o, 클로드 3, 제미니 1.5 같은 최신 모델은 도구를 능동적으로 활용하고 사고 흐름을 투명하게 드러내는 능력을 탑재했다. 나아가 이들은 판단과 계획, 메타 추론(자기 사고 검토) 기능을 갖춘 에이전트형 LLM으로 진화하고 있다. 여기에 인간이 설계한 논리 구조를 접목하면 오류를 최소화하는 고성능 AI 시스템 구축이 가능하다.

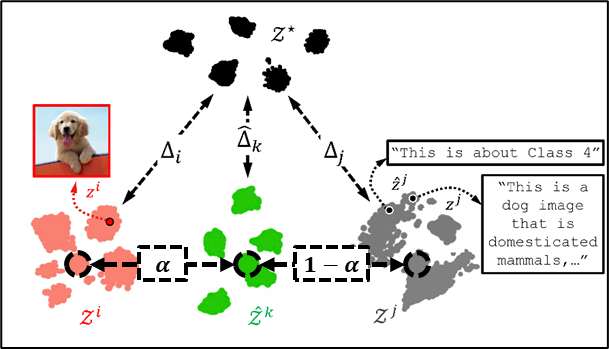

또 다른 시장파괴적 흐름은 오픈소스 LLM의 확산이다. 중국의 딥시크-R1은 추론에 최적화된 모델로, 기존의 ‘모델 크기’ 중심 경쟁을 ‘추론 성능’ 중심으로 전환했다. 특히 ‘증류’(distillation) 기술을 통해 이 모델의 능력을 큐원(Qwen)이나 LLaMA 같은 소형 모델에 이식하면서, 경량화된 모델도 대형 모델에 근접한 성능을 발휘할 수 있음이 입증됐다. 한국에서도 엑사원 딥 32B, 하이퍼클로바X 시드 3B 같은 경쟁력 있는 오픈소스 모델들이 세계적 수준의 추론 성능으로 주목받고 있다.

오픈소스 LLM은 산업 구조에도 영향을 미친다. 기업들은 이를 자사 업무 환경에 맞게 맞춤화하고, 폐쇄망에서 운영하여 보안을 강화할 수 있다. 더 나아가, 다양한 관점을 지닌 AI 에이전트를 설계해 서로 논의하게 만들면 단일 모델보다 뛰어난 결과를 얻을 수 있다. 실제로 법률 판단이나 의료 진단 분야에서 다중 에이전트가 토론을 통해 결론을 도출할 때 성능이 향상되는 것으로 나타났다.

이러한 기술 발전은 비즈니스 애플리케이션 개발 방식에도 구조적 변화를 일으키고 있다. 개인과 기업은 일정, 계약, 프로젝트 문서를 LLM에 연결하고 자연어로 작업을 지시한다. LLM은 이를 해석·추론해 업무를 수행하며, 비즈니스 운영뿐 아니라 전문가의 역할과 개발 체계까지 재편하고 있다. 프랑스 철학자 몽테스키외가 주창한 ‘견제와 균형’ 원칙이 공교롭게도 인간 사회보다 AI 시스템에서 더 정밀하게 구현되는 시대가 다가온다.

이수화 서울대 빅데이터 혁신융합대학 연구교수·법무법인 디엘지 AI센터장

![[컨콜] 정신아 카카오 대표 "오픈AI와 공동 개발 중…에이전트형 AI 연내 공개"](https://img.newspim.com/news/2025/02/04/250204120209389.jpg)