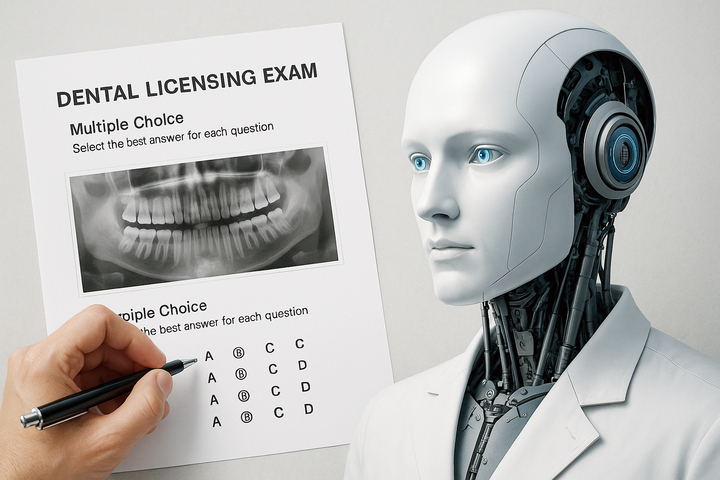

인공지능(AI) 챗봇이 각종 국가시험(이하 국시)에서 합격 수준임을 보여준 연구 결과가 속속 나온 가운데 이번엔 시험 ‘응시’가 아닌 ‘출제’에도 두각을 나타낸 것으로 나타났다.

국내 연구진이 대형 언어모델(Large Language Model·이하 LLM) AI 챗봇인 ChatGPT4o를 활용해 치과의사 국시 스타일의 문제를 생성한 결과 실제 출제위원에 필적하는 완성도 높은 문제를 만들어 낸 것으로 확인됐다. 경희치대 영상치의학교실 연구팀(김학선·김규태)이 진행한 이번 연구는 국제학술지 ‘Journal of Dental Sciences(IF 3.4)’ 최근호에 실렸다.

연구에서는 ChatGPT와 치대 교육 경력 8년 이상인 영상치의학과 전공인 출제위원이 각각 20개 문제씩, 총 40문제를 만들도록 했다. 문제는 국내 영상치의학 교과서 요약본을 기반으로 제작됐다. 이어 치대 본과 4학년 30명에게 30분간 문제를 풀도록 한 후 각 문제의 출처가 AI인지 출제위원인지 추정토록 했다. 또 문제의 난이도·변별력·오답효율성 등도 함께 분석했다.

연구 결과, AI가 출제한 문제가 출제위원과 견줄 만한 수준임을 보여줬다.

문제의 난이도 지수는 AI 출제 문제 세트가 55%, 출제위원은 50%로 모두 ‘우수한 범위(40~60%)’에 해당했고, 변별력은 AI 출제 문제가 0.29로 출제위원(0.14) 보다 높았다.

헷갈리게 잘 만든 오답 비율을 뜻하는 오답효율성은 AI와 출제위원 모두 80%로 동일했다. 특히 눈에 띄는 대목은 ‘난이도 조절 실패’ 문제의 수다. 출제위원이 만든 문제 중 8개가 지나치게 쉽거나 어려웠던 반면, AI는 2개에 불과했다. 응시자들의 문제 출처 추정 정확도는 63.3%(19명)에 그쳤다. AI 또는 출제위원이 만든 문제를 대체로 명확히 구분하기 어려웠다는 의미다.

하지만 한계도 분명했다. AI 출제 문제 가운데 3개는 교과서에 없는 내용을 포함한 ‘환각(hallucination)’ 사례로 지적됐다. 이는 수험생의 혼란과 채점 오류 가능성을 초래할 수 있다는 점에서 우려된다.

연구팀은 “AI 챗봇은 치과의사 국가시험 스타일의 문제를 출제위원 동등한 수준으로 생성할 수 있었다”면서도 “실제 시험 출제를 위한 도입은 환각 가능성을 고려해 철저한 검토와 감수를 전제로 신중하게 이뤄져야 한다”고 밝혔다.

![[기고]한국형 인공지능 어디로 가야 할까](https://img.etnews.com/news/article/2025/04/07/news-p.v1.20250407.e7d661af28264bba9a5f0ead10da9fd1_P3.jpg)

![“야근하고 왔더니 기억 안나고 멍하네요”…뇌 구조 바꾸는 ‘과로’ [건강+]](https://img.segye.com/content/image/2025/05/14/20250514506255.jpg)