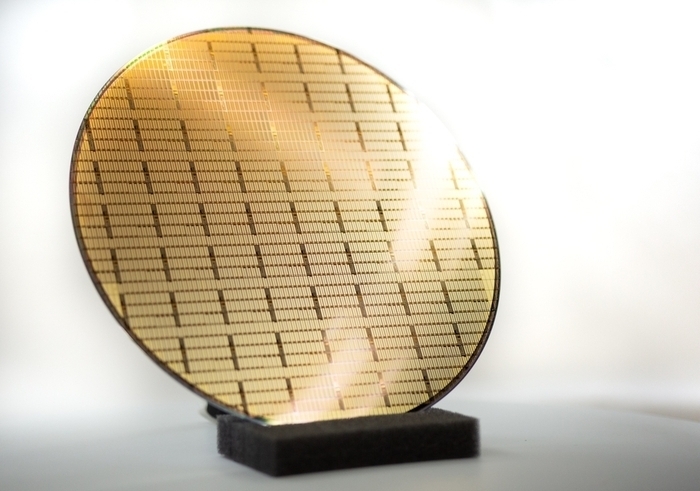

텐서처리장치(TPU)는 구글 경영진의 위기감에서 탄생했다. 2013년 인공지능(AI) 모델 연구에 속도를 내던 구글은 기존 중앙처리장치(CPU)와 그래픽처리장치(GPU)만으로 추후 AI 서비스 보급에 대비할 수 없다고 판단해 자체 AI 칩 개발에 나섰다.

아이언우드는 개별 칩 기준 4614TFLOPS(테라플롭스·초당 1조 번의 부동소수점 연산)의 연산력을 자랑한다. 엔비디아의 최신 GPU인 블랙웰(최대 약 2만 TFLOPS)에는 못 미치지만 전작인 H200(3958 TFLOPS)을 살짝 웃도는 수준이다. 메모리는 5세대 고대역폭메모리(HBM3E) 8개를 탑재한 것으로 보이며 대역폭은 32GB인 전작 대비 6배 높아진 192GB다.

개별 칩 단위 연산력은 여전히 엔비디아가 위지만 태초부터 AI 연산을 위해 기획된 만큼 TPU는 전력 대비 성능 면에서는 엔비디아를 능가한다는 게 업계 중론이다. 엔비디아의 근본적인 아키텍처는 그래픽 처리용에서 시작된 반면 TPU는 이름처럼 딥러닝 학습과 추론 과정에서 반복되는 행렬(텐서) 연산을 위해 개발됐다. 그래픽 처리나 범용 연산을 위한 불필요한 회로 등이 제거된 만큼 전력효율성이 높다. 가격 또한 GPU에 비해 구글 TPU가 저렴하다. TPU의 가격은 엔비디아 AI용 GPU 대비 절반 수준으로 전해졌다.

연결은 엔비디아의 최대 강점이기도 하지만 구글 TPU 역시 칩 간 연결성을 확대하는 데 집중하고 있다. 여러 개의 칩을 연결할수록 대규모 AI 모델을 학습하는 데 유리하기 때문이다. 엔비디아가 AMD 등을 따돌린 배경에도 NV링크·인피니밴드를 통한 높은 연결성이 자리하고 있다.

아이언우드는 칩 간 연결을 통해 최대 9216개의 TPU가 한 몸처럼 작동한다. 아이언우드 9216개가 연결되면 연산 속도는 최대 42.5EFLOPS(엑사플롭스·초당 100경 번의 부동소수점 연산)로 향상된다. 구글은 미국 팹리스 브로드컴과의 협력을 통해 칩 간 통신 부문에서 엔비디아를 능가하기 위해 기술 고도화에 전력을 쏟고 있다.