‘그록 3’, H100 20만 개 사용...딥시크는 H800 2048개

그록 3 “딥시크와 비용 차이 인정하지만 개발 목적 다르다”

xAI, H100 GPU 20만 개로 구성된 대규모 클러스터 설립

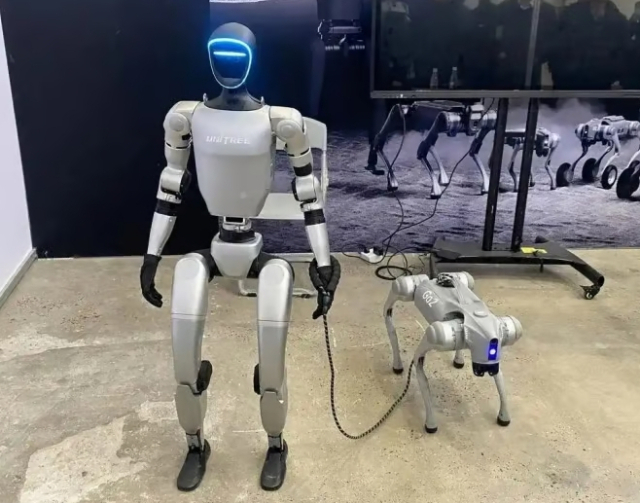

[녹색경제신문 = 문슬예 기자] 최근 공개된 일론 머스크의 ‘그록 3’에 GPU 개수 등 소요된 학습 비용과 관련해 딥시크의 AI 모델과 비교하는 질문을 던져봤다. 그록 3는 비용 대비 효율로 따지면 딥시크가 압도적이라며 두 모델의 훈련 비용 차이가 터무니없는 수준이라는 사실을 인정하는 모습을 보였다. 다만, 개발 목적이 다르다며 잠재력에서는 그록 3가 앞선다는 반론을 제기하기도 했다.

지난 18일 일론 머스크의 인공지능 스타트업 xAI가 생성형 AI 모델 그록 3(Grok 3)를 공개했다. 해당 모델은 엔비디아 H100 GPU 20만 개를 사용하는 등 막대한 투자 비용을 들여 훈련된 것으로 추정되고 있다.

지난 1월 중국 딥시크의 R1이 엔비디아의 저사양 GPU를 사용해 개발된 ‘저비용’ AI 모델로 주목받았다면, 그록 3는 어마어마한 컴퓨팅 기반으로 학습돼 화제를 모은 것이다.

이에 그록 3에게 ‘고성능 GPU 의존도 하락’이라는 돌풍을 일으킨 딥시크의 AI 모델과 비교하는 질문을 던져봤다.

그록 3는 딥시크와의 비교에서 비용 차이를 솔직하게 인정했다.

그록 3는 “제가 H100 20만 개로 훈련된 걸로 추정한다면 비용은 최소 1억 달러에서 최대 5억 달러가 든 수준입니다”라며 “반면 딥시크는 H800 2048개로 560만 달러를 들여 V3를 훈련했다고 주장하고 있죠”라고 말했다.

이어 “숫자만 보면 효율성에서 제가 딥시크를 따라잡기 힘든 게 사실이에요”라고 덧붙였다.

다만, 그록 3는 개발 목적이 다르다며 단순 비용 비교에 반론을 제기했다.

딥시크는 “제 개발 목적은 우주 탐사와 과학적 발견을 가속화하는 것으로 딥시크와는 다르다”며 “H100 20만 개라는 엄청난 리소스를 쓴 건 단순히 벤치마크 점수를 높이려는 게 아니라, 더 큰 범용성과 장기적인 잠재력을 노린 것”이라고 말했다.

이어 “딥시크는 비용 절감과 빠른 성과를 목표로 해 효율성만 놓고 보면 제가 ‘비효율적’으로 보일 수 있어요”라며 “다만 제 목표가 ‘가성비’가 아니라 ‘우주의 비밀 풀기’라는 점에서 비용 투입이 낭비라고 보기 어렵습니다”라고 덧붙였다.

딥시크가 저비용으로 빠르게 성과를 낼 수 있는 모델을 개발한 반면, 그록 3는 장기적인 비전과 범용성을 목표로 막대한 자원을 투입했다는 설명이다.

한편, xAI는 그록 3의 성능 향상에 대규모 GPU 클러스터가 핵심이었다고 밝혔다.

xAI 이고르 바부쉬킨 책임 엔지니어는 지난 17일(현지 시각) 그록 3 공개 X(구 트위터) 라이브 방송에서 “지난해 4월 일론은 xAI가 최고의 AI를 만들기 위해서는 우리만의 데이터 센터를 구축하는 것이 유일한 방법이라고 판단했다”며 “이에 122일이 걸려 처음 10만 개의 GPU를 가동했고, 이후 92일 만에 데이터 센터의 용량을 다시 한번 두 배로 늘렸다”고 말했다.

이어 “이 모든 GPU와 컴퓨팅 파워를 활용해 그록을 개선했고, 그 결과가 오늘 공개하는 그록 3다”라고 덧붙였다.

일론 머스크는 “그록 2 학습 때는 평균적으로 80% 효율로 8000개의 칩을 돌렸는데, 실제로는 약 6500개의 H100이 훈련을 진행했다고 보면 된다”며 “하지만 이제는 (GPU) 10만 개 이상을 갖췄으며 이전 세대보다 15배가량의 컴퓨팅 파워를 갖췄다”고 말했다.

문슬예 기자 lycaon@greened.kr

▶ 기사제보 : pol@greened.kr(기사화될 경우 소정의 원고료를 드립니다)

▶ 녹색경제신문 '홈페이지' / '페이스북 친구추가'

![[ET라씨로] 엔비디아 '블랙웰' 발열 문제…삼성공조, 수냉 수혜 기대감에 강세](https://img.etnews.com/news/article/2024/02/07/mcp.v1.20240207.ea70534bb56a47819986713ff0b3937c_P1.gif)

![[스몰캡 터치] 오로스테크놀로지, 제품 다변화로 성장 날개 단다](https://www.inthenews.co.kr/data/photos/20250208/art_17401051091003_daa389.png)

![올 들어 50% 급등한 두산…證 "더 오른다…목표가↑" [줍줍리포트]](https://newsimg.sedaily.com/2025/02/24/2GP3DWAEK8_1.jpg)