생성형 인공지능(AI) 모델의 개발부터 프로덕션 배포까지 가는 과정은 지난하다. 엔비디아가 지난 3월 내놓은 보도자료에 의하면, 시스템 지연시간과 처리량, 로깅, 모니터링, 보안 등을 AI 모델과 최적화하는 과정이 많은 시간을 소요하고 대규모의 경우 전문 기술과 플랫폼, 프로세스를 요구한다. 그리고 대다수 기업과 조직은 충분한 전문가 팀을 보유하지 못했다.

엔비디아는 이런 어려움을 겪는 조직을 돕는다며 지난 3월 ‘엔비디아 엔비디아 인퍼런스 마이크로서비스(Nvidia NIM, Nvidia Nvidia Inference Microservices)’란 걸 처음 소개했고 6월 정식 출시했다.

엔비디아 NIM, 동어를 반복하는 이상한 마법 주문 같은 이름의 이 솔루션은 생성형 AI 모델을 기업에서 빠르고 쉽게 배포할 수 있게 하는 것으로 설명된다. LLM의 프로덕션 배포로 갈 때 추론 성능을 최고로 끌어내는 게 쉽지 않다. 비싼 GPU를 사고도 저렴한 데스크톱급 성능을 얻을 수도 있다.

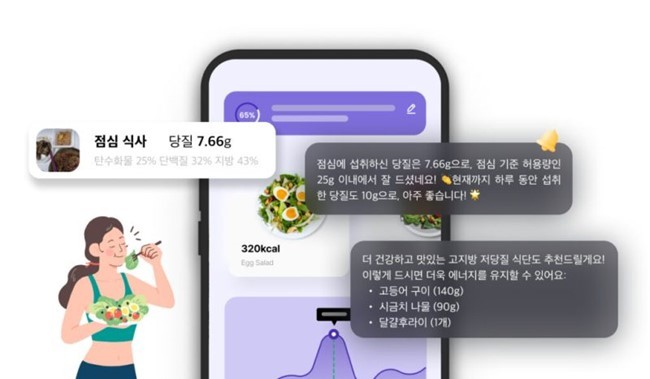

기업의 생성형 AI 도전이 더딘 데에 여러 이유가 있겠지만, 그 중 하나는 AI 애플리케이션을 기존의 백엔드 시스템에 통합시켜 실제 운영 서비스로 만드는 과정이 복잡하고 난해하기 때문이다.

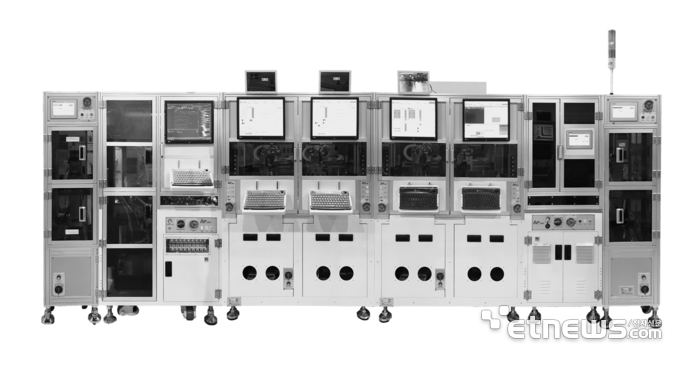

간단히 요약하면, 엔비디아 NIM은 특정 생성형 AI 모델을 담은 리눅스 컨테이너 이미지다. 컨테이너 안에 모델을 비롯해 CUDA, 트리톤 인퍼런스 서버, 텐서RT, 텐서RT-LLM, vLLM 등 모델 구동에 필요한 소프트웨어 요소도 같이 갖고 있다. 엔비디아가 특정한 모델을 자사 소프트웨어에서 최고 성능을 내도록 최적화, 검증하고 패키지로 제공하는 것이다. NIM으로 제공되는 모델은 엔비디아에서 직접 만든 것일 수도 있고, 협력 파트너에서 만든 것일 수도 있다.

데이터 정리, 프로파일링, 품질 관리, 학습, 배포, 운영화 등의 과정을 건너뛸 수 있다.

엔비디아는 LLM을 사용할 목적으로 자사 GPU를 구매하는 고객에게 엔비디아 AI 소프트웨어란 것도 함께 구독하라고 유혹한다(고가 모델은 5년 구독을 포함한다). 그런데 엔비디아의 여러 AI용 소프트웨어가 아무리 좋다고 해도 잘 못쓰는 기업과 조직이 대다수다. 엔비디아에서 제공하는 문서가 아무나 읽고 쓰기에 난해하기도 하고, 불친절하기 때문이다.

NIM은 이 엔비디아 AI 소프트웨어에 포함된다. 아무리 좋은 도구를 줘도 잘 쓰지 못하는 고객에게 아예 모델을 현업 추론 인프라에 배포하기까지 최적화와 빌드도 해주겠다는 것이다. NIM 이미지는 런타임에 감지되는 기초모델과 GPU 시스템의 각 조합에 대해 응답 대기 시간과 처리량을 자동으로 최적화한다. 쵸준 옵저버빌리티 데이터 피드와 GPU의 쿠버네티스 오토스케일링 등을 내장했다. NIM에 접근하는 트래픽이 증가하면 알아서 인프라를 늘린다는 소리다.

만약 필요하다면 기성품으로 만들어둔 AI 모델에 조직 내부 데이터를 학습시키고 맞춤화하는 미세조정도 가능하게 했다.

직접 LLM을 개발하는 기업이나 조직만 아니라면 엔비디아 GPU를 쓰면서 NIM을 거부할 이유는 적다. 심지어 엔비디아가 특정 모델의 추론 성능을 획기적으로 높이는 소프트웨어 업데이트를 공개했다면? 그냥 NIM 이미지의 최신 버전만 가져오면 끝난다.

LLM 운영에서 모델 서빙은 매우 까다로운 부분이다. 성능을 끌어내는 여러 방안이 고민됐는데 그중 vLLM은 추론 요청에 토큰을 빠르게 생성할 수 있게 하는 라이브러리로 대세로 자리잡았다. NIM은 텐서RT를 vLLM와 결합해 모델을 최적화한다.

NIM은 쿠버네티스 클러스터 환경에서 쓸 수 있다. 컨테이너와 헬름차트가 사전 구축돼 있다. 산업 표준 API로 통신하고, 도메인 특화 코드와 최적화된 추론 엔진, 커스텀 모델 지원 등을 담는다.

컨테이너 이미지란 얘기는 어디로든 옮겨가며 쓸 수 있다는 의미다. 엔비디아 DGX, 엔비디아 DGX 클라우드, 엔비디아 인증 시스템, 엔비디아 RTX 워크스테이션, PC 등 어디로든 리눅스 운영체제만 있으면 배포할 수 있다.

NIM의 API는 어떤 개발도구에서든 호출해 애플리케이션에 포함시키게 한다. 3줄의 코드만 있으면 AI 애플리케이션으로 변신한다.

NIM 이미지는 여러 분야로 나눠 제공된다. 대형언어모델(LLM), 비전언어모델(VLM), 음성, 디자인, 시뮬레이션, 바이오, 검색, 기후 및 날씨, AI 안전 등 9개로 나눠놨다.

메타 라마2와 라마3 시리즈, 미스트랄AI의 미스트랄과 믹스트랄 시리즈 등이나 딥마인드의 알파폴드2, 엔비디아의 어스2 시리즈, AI 생성 이미지 및 딥페이크 탐지, IBM 그래니트 시리즈, 셔터스톡과 게티이미지의 2D 및 3D 이미지 생성기 등 141개의 최적화된 모델을 바로 쓸 수 있다.

엔비디아는 최근 AI 에이전트 구축을 단순화하는 엔비디아 NIM 에이전트 블루프린트란 것도 선보였다. 사전 훈련된 AI 모델과 마이크로서비스를 포함하는 참조 사례집이다. 여러 시나리오에 맞는 AI 워크플로우를 NIM과 참조 코드, 문서, 도커 스크립트, 헬름차트 등으로 만들 수 있다.

NIM은 1년에 GPU 당 4500달러에 상업용도로 쓸 수 있다. 개발자와 연구자는 NIM을 90일 간 무료로 이용 가능하다. 유료 구독자라면 NIM의 구동을 블렉웰에서 하든, L40에서 하든 상관없다.

제공되는 NIM 중 어떤 환경에서든 실행할 수 있는 건 ‘런 애니웨어(Run Anywhre)’란 유형으로 구분된다. 프리뷰 단계는 엔비디아에서 제공하는 DGX클라우드 환경에서만 쓸 수 있다.

NIM 이미지를 다운로드 받을 수 있는 웹사이트는 마켓플레이스가 아니다. NIM 이미지를 최종적으로 공식 사이트에 올리는 건 엔비디아다. 모델 최적화와 이미지 패키지를 파트너에서 한다고 해도 엔비디아의 최종 승인을 거쳐야 한다. 완벽한 최적화와 최고 성능을 내기 위한 절차다.

다만, 이는 새로운 NIM 이미지의 출시를 막는 병목이기도 하다. 한 소식통에 따르면, 엔비디아 AI 팩토리팀에 들어오는 NIM 이미지 리뷰 요청 규모를 담당조직에서 원활히 소화하지 못한다고 한다. 라마3.3 70B처럼 확실히 인기있는 시리즈는 개발사 공개와 동시에 NIM으로 나기도 한다.

엔비디아 NIM은 AI옵스, 혹은 LLM옵스 필요를 없애는 듯 보이지만, 실제론 개발운영 주기 전반에서 일부만 간소화한다. 그리고 엔비디아 GPU를 사용하지 않는 경우 당연히 쓸 수 없다.

엔비디아는 생성형 AI 모델의 프로덕션 배포 시도가 올해 본격화될 것으로 보고 재빨리 NIM을 내놨지만 현실은 예상을 빚나갔다. 여전히 많은 기업은 생성형 AI 모델의 프로덕션 배포에서 어려움을 겪으며, 속도를 조절하고 있다. 그러나, 내년 본격 활용될 것으로 예상되고 있는 AI 에이전트는 추론, 즉 생성형 AI 모델의 프로덕션 배포를 전제로 한다. 여러 비즈니스 애플리케이션에서 제공되는 AI 에이전트가 중흥기를 맞는다면 생성형 AI 모델의 현업 배포도, 엔비디아 NIM도 함께 확산될 것으로 예상된다.

글. 바이라인네트워크

<김우용 기자>yong2@byline.network